O que realmente interessa é o seguinte: chamamos de “dado errado” qualquer informação que seja incoerente com todos os demais dados conhecidos. É o nosso único critério de certo ou errado. E, igualmente, é o critério da Máquina.

Isaac Asimov

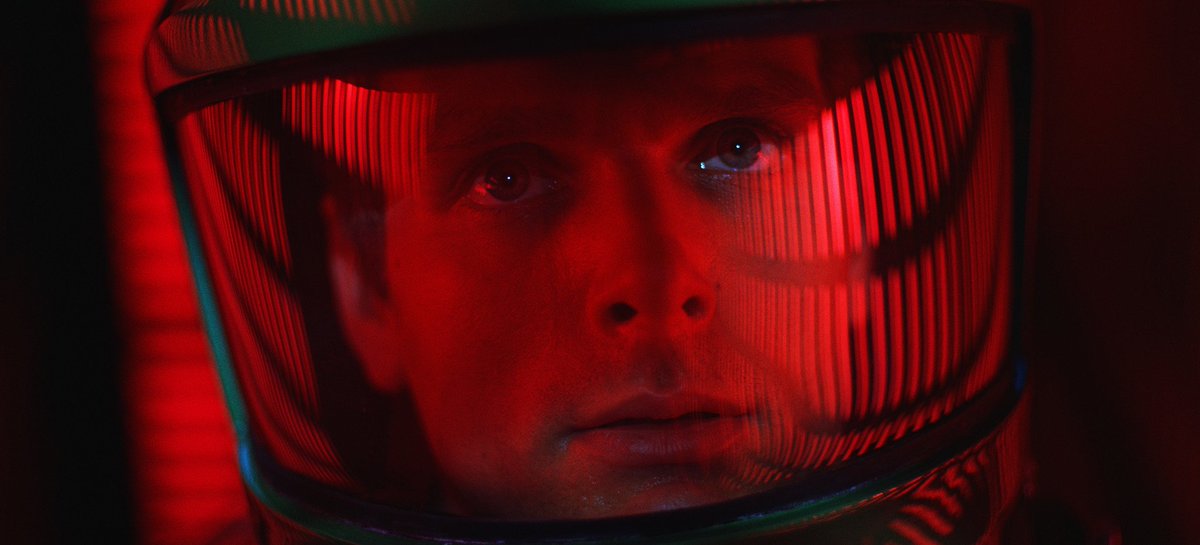

Foi na faculdade que me tornei uma leitora de ficção científica. Na época, lia, principalmente, Isaac Asimov (1920-1992) e Arthur Clarke (1917-2008), dois ilustres representantes desse gênero, cujas histórias conquistaram milhares de leitores em todo o mundo a ponto de seus livros renderam grandes sucessos do cinema como: 2001, Uma Odisseia no Espaço[1]e Eu, Robô[2]. Esses dois livros/filmes, assim como muitos outros, descrevem sociedades nas quais a tecnologia está tão avançada que supercomputadores controlam naves espaciais e robôs são projetados para servir e relacionar-se com os humanos. É claro que para manter o suspense da trama, na maioria dos casos, algo grave sempre acontece e as máquinas acabam não sendo tão confiáveis como se acreditava no início das histórias.

Em muitas das narrativas da ficção científica os computadores/robôs têm uma peculiaridade interessante: são capazes de aprender e, portanto, evoluir. Essa característica aterroriza os personagens humanos, pois se as máquinas são mais inteligentes que o homem, podem com facilidade dominar o mundo e, por consequência, a humanidade. Se esse enredo lembra o que ocorre na trilogia Matrix[3], você não está errado. Os filmes das irmãs Wachowski seguem o mesmo roteiro das histórias que envolvem essa relação complicada entre humanos e “máquinas pensantes”.

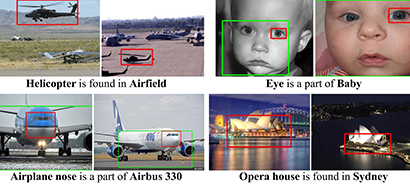

No entanto, essa realidade, estranha e até um pouco assustadora não está mais restrita a filmes e livros de ficção científica, ela já se encontra entre nós ou, pelo menos, entre aqueles que se dedicam ao estudo de novos programas computacionais. Nos Estados Unidos, na Universidade Carnegie Mellon, desde 2010, está em desenvolvimento um projeto, chamado Never Ending Image Learner (NEIL, em inglês ou, em português, Aprendiz Sem Fim de Imagens), cujo objetivo é verificar se os computadores conseguem reconhecer aspectos comuns encontrados em imagens. Seus desenvolvedores conseguiram criar arquiteturas de software que permitem a agentes inteligentes (leia-se computadores) aprenderem diversos tipos de conhecimento, continuamente, ao longo de muitos anos.

Os pesquisadores da universidade americana afirmam que NEIL, desde de 2010, já adquiriu uma base de conhecimento com 120 milhões de ideias diferentes, assim como a confiança para, por exemplo, servir chá com biscoitos enquanto aprende milhares de funções inter-relacionadas que melhoram sua competência de leitura. Além disso, NEIL está aprendendo a raciocinar sobre essa base de conhecimento para inferir conceitos que ainda não leu a partir daquelas que já leu. E, pasmem, segundo os programadores, NEIL também está criando novas qualidades relacionais, expandindo a ontologia que utiliza para representar conceitos que ainda desconhece.

Contudo, apesar de todos esses avanços, os cientistas ainda não estão satisfeitos. Entre outras melhorias, eles querem adicionar a NEIL a habilidade de autorreflexão e autoavaliação de seu próprio desempenho. Esse upgrade permitirá que NEIL concentre seus esforços de aprendizagem onde precisa ser melhorado. Até o momento, mesmo com um aprendizado semissupervisionado, NEIL tem conseguido aprender, simultaneamente, milhares de funções diferentes. Um problema ainda a ser resolvido é que essas funções, ao estarem densamente conectas a um grande número de restrições, reduzem a aprendizagem para outras tarefas. Quando esse obstáculo for removido a capacidade de aprender de NEIL não terá limites, ou melhor, terá os limites impostos por seus programadores.

Assustador? Um pouco. No meu caso, fico imaginando todas as histórias de ficção científica que já li transformando-se em realidade. Não há, por exemplo, como não lembrar de HAL, o computador psicótico de 2001. De qualquer maneira, mesmo que esse tipo de pesquisa seja um pouco intimidante para os leigos, é impossível acreditar que a ciência vai simplesmente deixá-la de lado. Do mesmo modo, fingir que isso não está acontecendo é enterrar a cabeça na areia como faz um avestruz. Então, o que podemos fazer? Na minha opinião, aquilo que tem mantido a humanidade viva durante milhares de anos: adaptação. É claro que essa adaptação deve ser feita com responsabilidade, sempre visando o melhor para o ser humano e o planeta.

Por isso, depois de ler a matéria sobre NEIL[4] resolvi consultar um dos livros de Isaac Asimov[5] e encontrei o que ele chamou de as “Três Leis da Robótica”[6]. Elas são regras ou princípios cujo objetivo é tornar possível a coexistência de robôs inteligentes e humanos; impedindo que aqueles venham a se rebelar contra ou mesmo subjugar estes. Ou seja, foi a tentativa literária de Asimov de controlar o antagonismo entre autômatos e seres biológicos inteligentes:

1ª Um robô não pode ferir um ser humano, ou, por inação, permitir que um ser humano seja ferido.

2ª Um robô deve obedecer às ordens recebidas dos seres humanos, a não ser no caso de estas ordens entrarem em conflito com a Primeira Lei.

3ª Um robô pode proteger a sua própria existência, contanto que tal proteção não entre em conflito com a Primeira ou Segunda Leis.

Leia com atenção essas Leis e prepare-se, pois, pelo visto elas poderão, em breve, se tornar uma realidade. É a ficção prevendo o futuro!

[1] Um filme americano de 1968 dirigido e produzido por Stanley Kubrick, co-escrito por Kubrick e Arthur C. Clarke.

[2] É um conto escrito por Isaac Asimov em 1950 que em 2004 tornou-se filme dirigido por Alex Proyas e estrelado pelo ator americano Will Smith.

[3] Em breve haverá uma continuação, The Matrix Resurrections, com previsão de lançamento, nos Estados Unidos para, 22 de dezembro de 2021.

[4] Disponível em: https://cacm.acm.org/magazines/2018/5/227193-never-ending-learning/fulltext.

[5] Eu, Robô (I, Robot, em inglês). Uma coletânea de contos escrita por Isaac Asimov e que já haviam sido publicados em revistas. O livro foi lançado em 2 de dezembro de 1950.

[6] Mais tarde Asimov acrescentou a “Lei Zero”, acima de todas as outras: “Um robô não pode causar mal à humanidade ou, por omissão, permitir que a humanidade sofra algum mal.